Webサイトやブログの検索順位を上げるために、コンテンツを黙々と作成している人も多いかもしれません。

設定したキーワードに関連する質の高いコンテンツを用意すればSEO対策はバッチリと考えているのかもしれませんが、実はそれだけでは不十分ですし、競合サイトを上回って検索上位に表示される可能性も低くなるでしょう。

もちろん質の高いコンテンツは検索順位を高めるのには不可欠ですが、より重要なSEO対策はコンテンツ制作前の「準備(初期設定)」にあります。

初期設定を徹底的に行えばSEO対策は8割方済んでいると言えるでしょう。

そこで今回はSEO対策でやっておくべき準備(初期設定)ついて解説していきます。

目次

コンテンツ作成の前に初期設定を徹底しよう!

狙ったキーワードに対する検索順位を高めるSEO対策において、質の高くユーザーにとって役に立つコンテンツの存在は不可欠です。

しかし、コンテンツばかりに集中するだけでは、SEO対策としては不十分になってしまします。

Googleの検索エンジンがどのような仕組みでWebサイトを評価しているのか、高く評価されるためのポイントには何があるのかを理解していなければ、検索上位に表示されるのは難しいでしょう。

コンテンツのことを考えるだけでなく、その前に徹底した準備(初期設定)が必要です。

キチンとした初期設定を行えば、自分のWebサイトを検索エンジンに正しく評価してもらえますし、その上で質の高いコンテンツを増やしていけば効果的なSEO対策ができるでしょう。

では、SEO対策に必要な準備として何をすべきなのか次以降で詳しくみていきましょう。

検索エンジンの仕組みを理解しよう

まずは、検索エンジンがどのような仕組みによって検索結果を表示しているのかについて理解していきましょう。

検索エンジンがWebサイトを評価する基準を知っていないと、評価されやすいWebサイトを作るのは難しいですよね。

具体的な評価軸を理解すれば、それに基づいた設計のWebサイトを作成することができます。

検索エンジンが検索結果を表示する流れとしては以下の3ステップになっています。

- クローリング:インターネット上に公開されているWebサイトの情報を取得

- インデックス:クローラーが収集したWebサイトの情報をデータベースに保管

- ランキング:保管されたWebサイトを評価して有益さの順位を付ける

では、それぞれのステップについて具体的に何が行われているのか詳しく見ていきましょう。

クローリング

「クローリング」とは、インターネット上に公開されているWebサイトの情報を取得することを指します。

検索エンジンには、Webサイトの情報を収集するための「クローラー」があり、Webサイトを見回っていくことで取得した情報をデータベースに蓄積しています。

クローラーがWebサイトから収集する情報には以下のようなものが挙げられます。

- 文字情報

- サイト構成

- リンクの有無

- ページの表示速度

これ以外にもありますが、ポイントとしては「ユーザーにとって役に立つサイトかどうかを判断するための情報」であることです。

例えば、ページの表示速度が遅ければユーザーにストレスを与えてしまいますし、検索キーワードに対して関係のない内容が書いてあるサイトも役には立ちません。

検索エンジンは、ユーザーにとって有益なサイトを高く評価する傾向にあるため、上記のような情報を整理しておく必要があるでしょう。

インデックス

「インデックス」は、クローラーが収集したWebサイトの情報をデータベースに保管することを指します。

ユーザーが検索したキーワードに対して、データベースに蓄積された情報から適したものを探し出して表示していきます。

ランキング

「ランキング」では、インデックスに蓄積されたWebサイトを評価して、ユーザーにとって有益である順番にランク付けをすることを指します。

評価による順位付けを行う仕組みのことを「アルゴリズム」と呼び、Googleの検索エンジンでは200を超えるアルゴリズムがあると言われています。

それでも重要なのは「ユーザーにとって役に立つコンテンツかどうか」なので、検索から訪れたユーザーにとって有益で質の高いコンテンツを作成することは、SEO対策において非常に効果的です。

Google Search Consoleに登録しよう

検索エンジンがWebサイトを評価する仕組みを理解したら、評価されやすいWebサイトを作成していきます。

表示速度やリンクの作成、コンテンツの拡充など、さまざまな方法によってSEO対策を行っていきますが、これらのプロセスの間に「何を改善すべきなのか」を具体的に把握しておく必要があります。

Google Search Consoleは、Googleが無償で提供しているWebサイトを分析するためのツールで、SEO対策に必要な情報を提示してくれます。

- アクセス数

- 流入キーワード

- リンク数

- 検索順位

このツールを利用すればSEO対策が効率的かつ効果的に行えるので、Webサイトを運営する上で必須といえるでしょう。

では、そんなGoogle Search Consoleの登録方法と利用のポイントを詳しく見ていきましょう。

登録方法

Google Search Consoleへの登録は以下の手順で行います。

- Googleアカウントを作成する

- 「Google Search Console」にアクセスする

- 作成したアカウントでログインする

- 登録するWebサイトのURLを入力し「プロパティを追加」をクリックする

- Googleにサイト運営者であることの認証を行う

- 登録完了

「5.Googleにサイト運営者であることの認証を行う」については、Webサイト上にGoogleが指定したファイルをアップロードし、トップページのソースコードに指定のコードを埋め込みます。

利用のポイント

Google Search Consoleは、Webサイトの状況を細かく教えてくれるツールです。

アクセス数や流入キーワード、リンク数などの推移を見ながら、検索順位がどのように変動しているかといった情報を見ることで、SEO対策に何が必要になるのかが見えてきます。

また、Webサイトにアクセスするユーザーの細かい動きも分析データとして確認できるため、強化や改善すべきポイントも把握できるでしょう。

これらのデータを元にGoogleからアドバイスが届けられることもあります。

Webサイトの検索順位を高めるための方法を指摘してくれることもあるので、次にすべき施策が具体的に見えてくるでしょう。

これらの機能が全て無料で使えるので、Webサイトを運営しながらSEO対策をするなら必須のツールと言えますね。

サイトマップを作成しよう

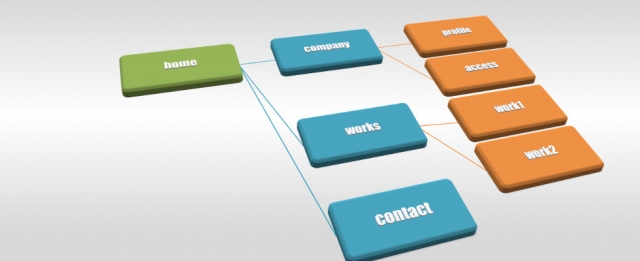

サイトマップとは、Webサイト全体のページ構成を一覧で表示しているページのことを指します。

トップページや各記事、会社概要、問い合わせなど、1つ1つのページがどのようなリンクで繋がっているかがまとめられています。

サイトマップには主に「ユーザー向け(HTML形式)」と「検索エンジン向け(XML)」の2つがあり、それぞれに役割が異なります。

- ユーザー向け(HTML形式):利用者にサイト全体の構成を案内する

- 検索エンジン向け(XML):検索エンジンのクローラーにサイト全体の構成を伝える

Webサイトの利便性向上やSEO対策に必要となるので、サイトマップを必ず用意しておきましょう。

SEO上の役割

ユーザー向け(HTML形式)のサイトマップは、サイトを訪れたユーザーに対して、Webサイト全体がどのような構成になっているのかを案内します。

どこにユーザーが求める情報が記載されているのか、サイトマップを見れば一目で把握できるようになるため、Webサイトの利便性を高め、アクセス数や滞在時間の向上に繋げることができます。

検索エンジン向け(XML)のサイトマップは、Webサイトの情報を収集するクローラーに対して、適切に各ページの情報を検出させるために作成します。

Webサイトを作成しただけではクローラーが上手く機能せず、一部のページが検出されず、インデックスに蓄積もされないため検索結果に表示されなくなります。

サイトマップを検索エンジンに送信することで検出漏れを防ぎ、サイト全体が検索結果に表示されるようにするためにも、サイトマップを作成しておきましょう。

作成方法

ここでは、検索エンジン向けのサイトマップ(sitemap.xml)の作成方法について解説します。

作成したサイトマップはGoogle Search Consoleを通じて送信してください。

では、ツールを用いた方法とワードプレスのプラグインを用いた方法をそれぞれ解説していきます。

ツールを利用する

「sitemap.xml Editor」を使えばサイトマップを自動的に作成できます。

上記のサイトにアクセスし、サイトに関する以下の項目を設定してください。

- URL

- 最終更新日(lastmod)取得の有無

- 更新頻度(changefreq)記述の有無

- 優先度(priority)設定の有無

- 除外したいディレクトリの指定

- 同一タイトルURLの除外設定

あとは「サイトマップ作成」をクリックするだけです。

ワードプレスのプラグインを利用する

ワードプレスを利用する場合は「Google XML Sitemaps」というプラグインを使ってください。

プラグインをインストールし、有効化することでサイトマップを自動的に生成してくれます。

設定の際は1つずつチェック項目を埋めていくだけで済むので、コード知識などがなくても簡単に扱えるでしょう。

Google Search Consoleを使って送信する

作成したサイトマップはGoogle Search Consoleを使って、Googleに送信します。

- サイトマップ(sitemap.xml)をHTMLサーバーのルートディレクトリサーバーに設置する

- Google Search Consoleにログインする

- sitemap.xmlを登録したいサイトのプロバディを選択する

コンテンツ量が多くなるほど、サイトマップの存在によるクローラーの検出漏れ防止のメリットが高まってくるので、サイト作成時に用意しておきましょう。

robots.txtをマスターしよう

「robots.txt」とは、検索エンジンのクローラーが行うクローリングを最適化することで、指定したページを確実に検索結果に表示してもらうために使用するツールです。

Webサイト内で検索結果に表示したいor表示したくないページを指定して、効率よくクローリングをしてもらうために設定していきます。

では、そんなrobots.txtの扱い方について詳しく見ていきましょう。

基本的な書き方

robots.txtは主に以下の4つの項目から構成されています。

- User-agent:ユーザーエージェントを指定

- Disallow:クロールをブロックするページを指定

- Allow:クロールさせるページを指定

- Sitemap:クローラー用のサイトマップの場所を指定

主に利用頻度の高い項目としては「User-agent」と「Disallow」の2つのみです。

「Allow」は基本的に指定しなくてもクローラーが勝手に収集していくので、改めて設定する必要はありません。

「Disallow」でクロールをブロックしたページの一部分だけクロールさせたい場合などに「Allow」を使ってください。

User-agent

User-agentでは、クローラーのユーザーエージェントを指定します。

ユーザーエージェントの種類としては以下の通りです。

- Googlebot(Googleウェブ検索):Googlebot

- ニュース用Googlebot:Googlebot-News

- 画像用Googlebot:Googlebot-Image

- 動画用Googlebot:Googlebot-Video

- Google Adsense:Mediapartners-Google

- Google AdsBot:AdsBot-Google

- Googleモバイル:Googlebot

- モバイルウェブAndroid用AdsBot:AdsBot-Google-Mobile

- モバイルウェブ用AdsBot:AdsBot-Google-Mobile

書き方の例としては以下のようになります。

User-agent : *

※「*」は全てのクローラーを受け入れるという記号

User-agent : Googlebot

※Googlebotのみを受け入れる場合

受け入れるクローラーのユーザーエージェントを入力してください。

Disallow

Disallowでは、クローラーをブロックするページを指定していきます。

主な書き方としては下記を参照してください。

| Disallowの基本的な書き方 | |

|---|---|

| Diallow : / | 「/」を使用するとサイト全体をブロックする |

| Diallow : /sample-directory/ | ディレクトリとその中のコンテンツをブロックする |

| Diallow : private_file.html | ページのリストを記述してブロックする |

| Diallow :/*? | 「?」を含む全てのURLに対するアクセスをブロックする |

| Diallow :/mypage/ | マイページをブロックする |

| Diallow :/images/dogs/jpg | Google画像検索で特定の画像をブロックする |

| Diallow :*.gif$ | 特定のファイル形式のファイルをブロックする(例:gif) |

設置場所

robots.txtは「robots.txt」という名称で保存をし、テキストファイルとして自分のドメインのルートにアップロードしてください。

テスターによる確認方法

robots.txtが正しく作成できているかは「robots.txtテスター」に送信をして確認できます。

基本的な使い方は下記を参照してください。

- 「robots.txtテスター」にアクセスする

- 中央部にrobots.txtが表示されていることを確認する

- 「送信」をクリックする

画面下部ではブロック(Disallow)したURLが正しくブロックされているか確認できます。

まとめ

SEO対策に必要な準備(初期設定)について解説しました。

良質なコンテンツを作成するのは、検索エンジンに高く評価されるために必要なポイントではありますが、より効果的に評価されるためにも今回紹介した準備を忘れずに行いましょう。

ユーザーにとって有益なコンテンツが高く評価される原則は変わりませんが、評価される仕組みや評価されやすくなる設定をすることで、より効果的なSEO対策が可能になります。

Webサイト運営を始める前に綿密な準備をして、コンテンツ作成を開始してみてください!

コメントを残す